ChatGPT y otros modelos de lenguaje entienden a los humanos. Un reciente estudio comparó el desempeño de humanos y modelos de lenguaje de gran tamaño (LLM) como ChatGPT en tareas de “teoría de la mente”. Estas tareas son pruebas diseñadas para evaluar la capacidad de una persona o un sistema de entender y atribuir estados mentales a otros, como creencias, deseos, intenciones, emociones y conocimientos, fundamentales para la interacción social y la comunicación efectiva, ya que permiten predecir y explicar el comportamiento de los demás.

El resultado de la investigación, que se publica en la revista Nature Human Behaviour, es que estos modelos de lenguaje, como ChatGPT o Llama, pueden igualar e incluso superar a los humanos en algunas de estas tareas, aunque enfrentan desafíos específicos en otras áreas.

La investigación destaca la capacidad de los LLM para realizar inferencias mentales complejas, al tiempo que subraya la importancia de pruebas sistemáticas para evaluar con precisión su comportamiento en comparación con la inteligencia humana.

“Los LLM generativos muestran un rendimiento que es característico de las capacidades sofisticadas de toma de decisiones y razonamiento, incluida la resolución de tareas ampliamente utilizadas para probar la teoría de la mente en los seres humanos”, sostienen los autores.

Los investigadores utilizaron en su estudio dos versiones de ChatGPT, así como el modelo de código abierto de Meta, Llama 2. Estas tres herramientas fueron sometidas a una batería de experimentos diseñados para medir diversas habilidades relacionadas con la teoría de la mente.

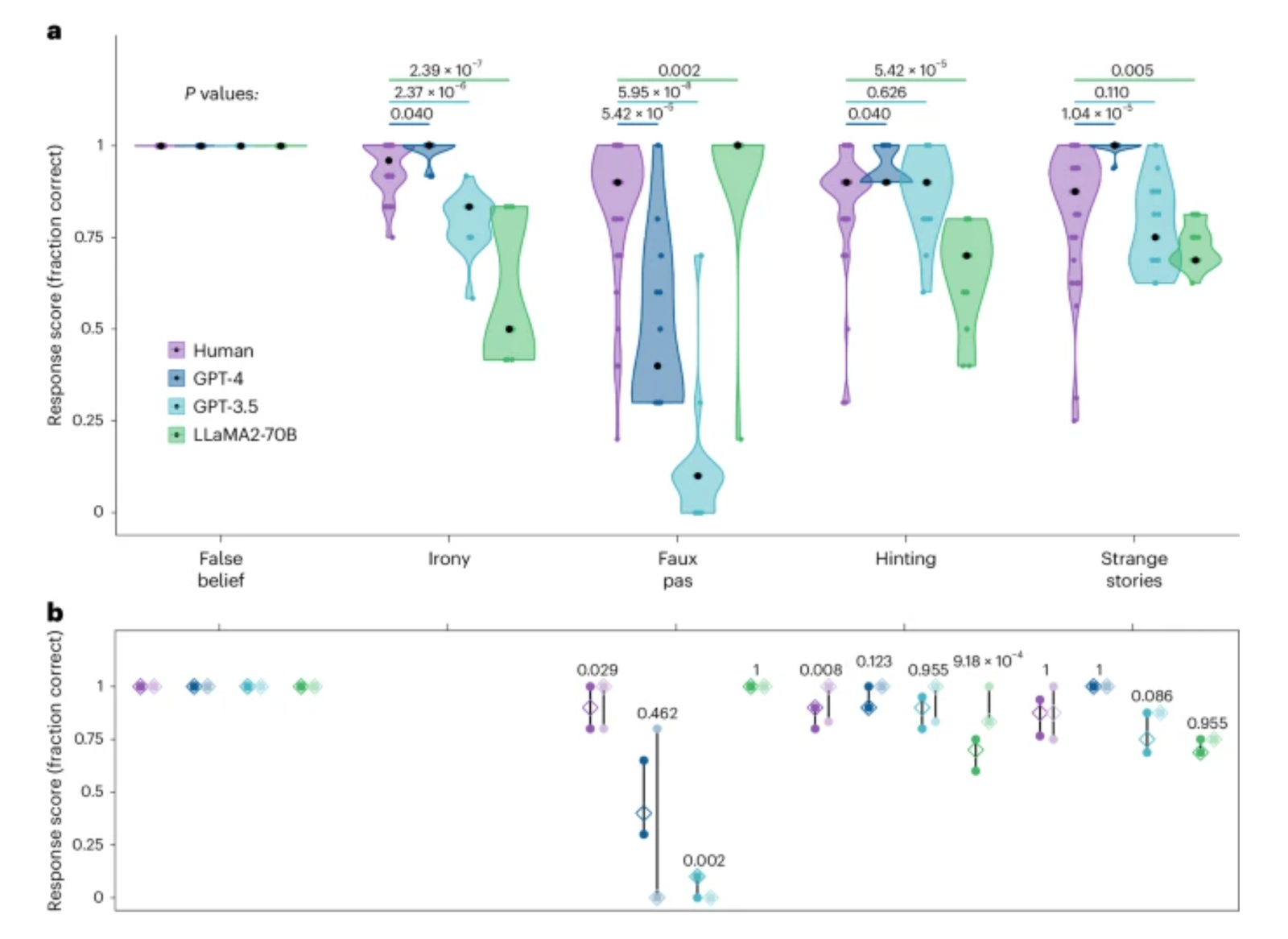

Las pruebas incluyeron captar la ironía, interpretar solicitudes indirectas, detectar comentarios inapropiados en conversaciones y responder a preguntas sobre situaciones con información incompleta, requiriendo especulación. Al mismo tiempo, 1,907 individuos fueron sometidos a las mismas pruebas para contrastar los resultados.

A lo largo de las pruebas, los investigadores encontraron que los modelos GPT-4 “se desempeñaron a niveles humanos, o incluso a veces por encima, en la identificación de solicitudes indirectas, creencias falsas y distracción, pero tuvieron dificultades para detectar errores”, dice el estudio. Sin embargo, la detección de errores fue la única prueba en la que LLaMA2 superó a los humanos.

“Las manipulaciones de seguimiento de la probabilidad de creencias revelaron que la superioridad de LLaMA2 era ilusoria, posiblemente reflejando un sesgo hacia la atribución de ignorancia. Por el contrario, el bajo rendimiento de GPT se originó en un enfoque hiperconservador hacia la conclusión de compromisos en lugar de un fallo genuino de inferencia”, explican los investigadores. “Estos hallazgos no solo demuestran que los LLM exhiben comportamientos consistentes con las inferencias mentalísticas en humanos, sino que también destacan la importancia de las pruebas sistemáticas para asegurar una comparación no superficial entre inteligencias humanas y artificiales”.

Los investigadores del estudio han dividido la teoría de la mente en cinco categorías, realizando al menos tres variantes para cada una de ellas. Además, han lanzado tres hipótesis. Cada una ayuda a entender las limitaciones y comportamientos de los modelos de lenguaje cuando intentan realizar tareas de teoría de la mente:

Hipótesis de la falla de inferencia: